Gaza: el genocidio asistido por IA

Las distopías solían ser advertencias literarias. Hoy, en Gaza, algoritmos y drones deciden quién vive y quién muere.

Durante décadas, las distopías ocuparon un lugar en la literatura como advertencias. Eran espejos deformados que proyectaban futuros posibles en los que la tecnología, el poder político o las ideologías llevaban a la humanidad a escenarios de represión, vigilancia y desigualdad extrema. 1984 de George Orwell nos mostró un mundo donde la vigilancia absoluta convertía la vida en un espacio de sospecha permanente; El cuento de la criada de Margaret Atwood planteó un futuro donde los cuerpos de las mujeres eran sometidos a un régimen teocrático y patriarcal; Neuromante de William Gibson introdujo la idea de un ciberespacio controlado por poderes económicos y militares capaces de reducir la vida a flujos de información.

Lo terrible es que, en la actualidad, no hablamos ya de advertencias ni de metáforas. En Gaza, esas ficciones han encontrado un eco perturbador en la realidad. Allí, drones y algoritmos participan activamente en la decisión sobre quién vive y quién muere. El futuro distópico imaginado en la literatura se ha convertido en un presente sangriento, donde la inteligencia artificial, en lugar de servir para preservar la vida, se emplea como instrumento de exterminio.

La crudeza de los números

Las cifras que provienen de Gaza tienen una dimensión que desborda la capacidad de asimilación humana. Los informes de organismos internacionales, como la ONU, UNICEF o Save the Children, describen un escenario devastador:

- Más de 42.000 palestinos asesinados desde octubre de 2023, de los cuales alrededor del 70 % son mujeres y niños (ONU).

- Más de 20.000 niños muertos en menos de dos años de ofensiva (Save the Children).

- Más de 50.000 niños muertos o heridos desde el inicio de la ofensiva (UNICEF).

- Cada hora, al menos un niño palestino muere (Save the Children).

- 34.000 niños heridos, muchos de ellos con amputaciones permanentes (UNICEF).

- 1,7 millones de personas desplazadas, casi un millón de ellas niños (UNRWA).

- El 80 % de los hospitales y centros de salud destruidos o inoperativos (OMS).

- Más de 600.000 niños sin acceso a educación porque el 75 % de las escuelas han sido dañadas o arrasadas (UNESCO).

- El 95 % de la población de Gaza carece de agua potable (ONU Agua).

- 1 de cada 3 menores de 5 años padece desnutrición aguda (UNICEF).

Detrás de cada número hay un nombre, un rostro, un cuaderno escolar que no volverá a abrirse, una cama que permanecerá vacía.

Las estadísticas muestran la magnitud del crimen. Pero para comprender cómo se sostiene este exterminio, es necesario observar la maquinaria tecnológica y corporativa que lo hace posible.

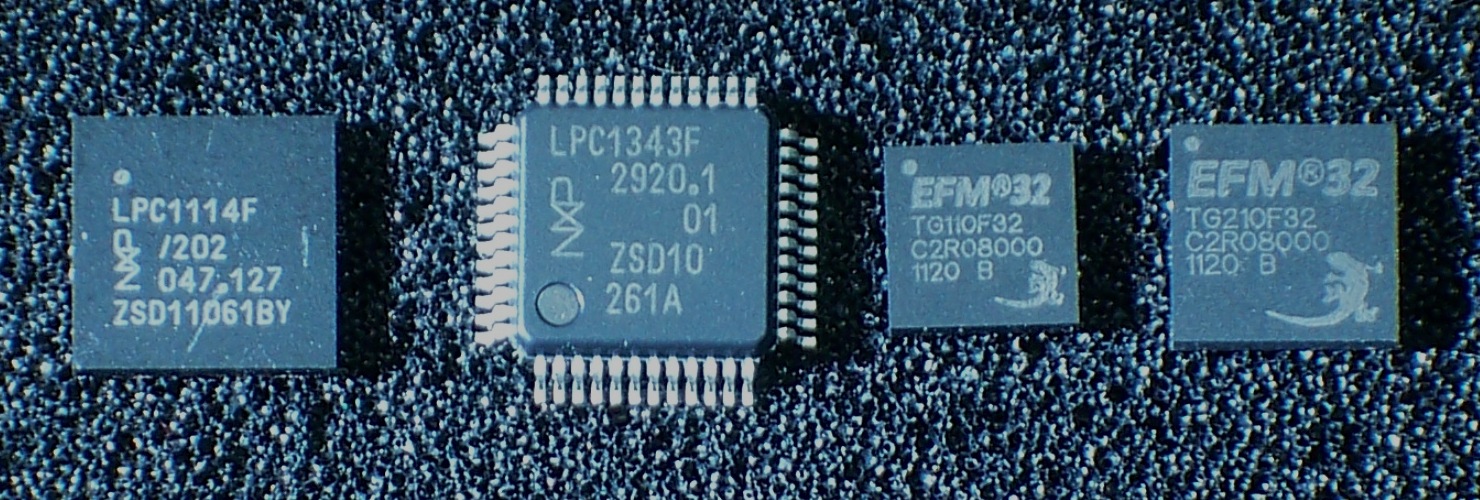

La infraestructura del genocidio

El exterminio que tiene lugar en Gaza no se explica únicamente por la acción directa de un ejército. Se sostiene en una compleja infraestructura tecnológica y corporativa que convierte la ocupación en un sistema administrado de forma remota y sistemática.

- Palantir ha proporcionado software de análisis de datos capaz de integrar información biométrica, movimientos de población y comunicaciones. Bajo el lema de “inteligencia para salvar vidas”, ofrece en realidad la capacidad de identificar y marcar personas para su eliminación.

- Google y Amazon, mediante el proyecto Nimbus, ofrecen la infraestructura de nube que permite almacenar y procesar imágenes de satélite, grabaciones de drones y bases de datos masivas sobre la población palestina. Ingenieros de estas compañías han denunciado públicamente la complicidad de su trabajo.

- Microsoft, a través de Azure y sus vínculos con OpenAI, sostiene operaciones de inteligencia que refuerzan la capacidad militar israelí. Aunque la empresa intenta distanciarse de los usos concretos, proveer esa infraestructura técnica en un contexto de ocupación militar es ya corresponsabilidad.

- Elbit Systems, la principal compañía armamentística israelí, produce drones y sistemas autónomos desplegados constantemente sobre Gaza. Estos dispositivos transmiten datos que alimentan algoritmos de decisión, automatizando el proceso de identificación de blancos.

Dentro del ejército israelí, programas como Lavender (que etiqueta supuestos combatientes entre la población civil), Gospel (que recomienda bombardeos de edificios completos) o Where’s Daddy (que rastrea a padres para atacarlos cuando están con sus familias) muestran hasta qué punto la represión ha sido traducida al lenguaje de la informática.

Apartheid digital

El concepto de apartheid no es una metáfora ligera en el caso palestino: la ONU y diversas organizaciones de derechos humanos lo utilizan para describir el régimen de segregación impuesto por Israel. Sin embargo, lo que antes se sostenía mediante muros físicos, checkpoints y permisos arbitrarios, hoy se refuerza a través de lo que puede llamarse un apartheid digital.

En este sistema, la vida cotidiana de los palestinos se convierte en un flujo de datos: huellas digitales, fotografías, escaneos faciales y registros de movimientos se integran en programas de vigilancia masiva. Cámaras con reconocimiento facial en calles y pasos fronterizos identifican automáticamente a las personas, asignándoles etiquetas como “sospechoso”, “permitido” o “objetivo”, sin posibilidad de apelación.

La segregación atraviesa incluso el acceso a servicios básicos: atención médica, permisos de trabajo, movilidad cotidiana. Lo que antes dependía de la arbitrariedad de un soldado, hoy se delega en algoritmos que operan con la frialdad de la estadística y el sesgo de sus programadores.

Empresas como las mencionadas anteriormente construyen un muro invisible que complementa los de hormigón: un muro de datos que clasifica, separa y decide. Gaza se convierte, de este modo, en un laboratorio de control poblacional, un modelo exportable de represión global.

Genocidio algorítmico

La Convención para la Prevención y la Sanción del Delito de Genocidio de 1948 establece que es genocidio cualquier acto cometido con la intención de destruir, total o parcialmente, a un grupo nacional, étnico, racial o religioso.

Gaza cumple con todos esos criterios: asesinatos masivos, daños físicos y psicológicos irreparables, sometimiento a condiciones de vida inhumanas, desplazamiento forzoso y destrucción del futuro de toda una generación.

Datos y criterios de manera más visual:

| Criterio de la Convención | Descripción | Evidencia en Gaza |

|---|---|---|

| Asesinatos masivos | Matanza de miembros del grupo. | Más de 42.000 palestinos asesinados desde octubre de 2023, de los cuales el 70 % son mujeres y niños (ONU). |

| Daños físicos o mentales graves | Infligir sufrimientos severos al grupo. | 34.000 niños heridos, muchos con amputaciones permanentes (UNICEF). Alta prevalencia de trauma psicológico. |

| Condiciones de vida destructivas | Someter al grupo a condiciones destinadas a su destrucción física. | El 95 % de la población sin agua potable (ONU Agua). 1 de cada 3 menores de 5 años con desnutrición aguda (UNICEF). El 80 % de hospitales destruidos (OMS). |

| Medidas para impedir nacimientos | Acciones que busquen frenar la continuidad del grupo. | Bombardeos de hospitales y maternidades; restricciones severas a la atención médica y desplazamiento forzoso de mujeres embarazadas. |

| Traslado forzoso de niños | Deportación o sustracción de menores de su comunidad. | 1,7 millones de desplazados internos, casi un millón niños (UNRWA). Separación de familias en ataques y traslados forzados. |

Lo inédito es la dimensión tecnológica. Nunca antes la destrucción de un pueblo había sido tan meticulosamente administrada por algoritmos. Las personas son reducidas a entradas en una base de datos, a puntos en un mapa, a variables dentro de un cálculo. El juicio humano ha sido sustituido por procesos automáticos que deciden la vida o la muerte.

Es un genocidio algorítmico, un exterminio planificado que utiliza la frialdad del cálculo desde la comodidad de la oficina para borrar a un pueblo.

Filosofía y distopía

La filosofía había anticipado, de distintas maneras, los riesgos de una técnica sin freno ético.

- Hannah Arendt analizó la banalidad del mal: el horror no requiere monstruos excepcionales, sino individuos obedientes que cumplen órdenes sin reflexionar. En Gaza, esa obediencia se traduce en líneas de código escritas por ingenieros que nunca ven a las víctimas.

- Günther Anders habló del “desfase prometeico”: la brecha entre lo que la humanidad es capaz de producir tecnológicamente y lo que es capaz de imaginar y controlar moralmente. En la era nuclear, señalaba que la bomba atómica era tan devastadora que ni siquiera quienes la construyeron podían representar mentalmente su alcance. Gaza confirma esta tesis: tecnologías capaces de procesar millones de datos en segundos son, sin embargo, incapaces de reconocer la humanidad singular de cada vida.

- Martin Heidegger advirtió que la técnica moderna no es solo un conjunto de herramientas, sino un modo de “desvelar” el mundo que convierte todo —la naturaleza, los cuerpos, incluso a los seres humanos— en recursos disponibles. En Gaza, las personas no son reconocidas en su dignidad, sino reducidas a materia prima para un cálculo militar.

La literatura distópica también había dejado advertencias que hoy parecen profecías: Orwell imaginó un mundo de vigilancia perpetua; Atwood denunció la represión de cuerpos y libertades; Gibson vislumbró un futuro donde el poder militar y económico convierte a las personas en flujos de información; Bradbury y Huxley mostraron sociedades donde la memoria y los deseos eran moldeados para sostener la opresión.

El espejo de la IA

La inteligencia artificial no tiene moral ni voluntad propia: es un instrumento. Su carácter depende del uso que se le dé y de los fines para los que se programe. En Gaza, se ha convertido en una extensión técnica de la violencia estatal.

Lo inquietante es que este tipo de uso no solo amplifica la violencia, sino que la normaliza. Al delegar decisiones de vida o muerte en algoritmos, los responsables diluyen su responsabilidad moral. La máquina no siente culpa; el programador puede alegar desconocimiento; el político puede ampararse en la eficiencia técnica.

El genocidio se recubre con el barniz de la objetividad, como si los cálculos pudieran justificar lo injustificable.

Lo que deberíamos preguntarnos ante esta situación

El caso de Gaza obliga a plantear preguntas que atraviesan nuestra idea de humanidad y de futuro. ¿Tiene sentido hablar de “ética en inteligencia artificial” cuando las principales empresas del sector proveen tecnología utilizada para seleccionar objetivos militares entre la población civil? ¿Dónde se sitúa la responsabilidad de corporaciones como Google, Amazon, Microsoft o Palantir cuando sus infraestructuras sostienen operaciones que desembocan en la muerte de miles de niños?

Más allá del presente inmediato, surge otra cuestión inquietante: ¿en qué momento las distopías literarias dejaron de ser advertencias para convertirse en manuales de gestión del presente? Lo que antes leíamos como ficción crítica se materializa como política de Estado y estrategia empresarial. Y si esto ocurre hoy en Gaza, ¿qué impide que mañana se reproduzca en otros lugares bajo nuevas formas de control y represión?

Estas preguntas deberían recordarnos que lo que allí ocurre no es un conflicto lejano, sino el reflejo más oscuro de lo que podemos llegar a ser como humanidad.

Cuando las historias se vuelven Historia

El genocidio en Gaza no es únicamente un crimen contra un pueblo concreto: es también un espejo para la humanidad. Nos muestra cómo la tecnología, en lugar de liberarnos, puede convertirse en un instrumento de exterminio cuando cae en manos de quienes buscan dominar y destruir.

La combinación de violencia militar, vigilancia tecnológica y complicidad corporativa ha creado un escenario que parecía reservado a la ficción distópica. Si no se detiene este proceso, las distopías dejarán de ser advertencias literarias para consolidarse como nuestra historia repetida y como nuestro fracaso colectivo.

Comentarios (1)

Aún no hay comentarios. ¡Sé el primero en comentar!